AIが「協力」して難問を解く:Sakana AIの挑戦と、まるで人間の試行錯誤

Tak@です。普段はシステムインテグレーターとして働きながら、趣味で生成AIを活用したWebサービスを開発しています。

今回は、AIがまるで人間のように協力し合い、難しい問題を解決する最先端の技術について、皆さんと一緒に考えていきたいと思います。

人間社会の知恵に学ぶ:なぜ今、AIの「協力」が注目されるのか?

人間は、一人では解決できないような大きな問題を、互いに協力し合うことで乗り越えてきました。アポロ計画やインターネットの誕生、ヒトゲノム計画など、歴史に残る偉業は、決して一人の天才によって成し遂げられたものではありません。

多様な専門知識や考え方を持つ人々が知恵を出し合い、時にはぶつかり、融合することで、数えきれないほどの技術的な壁を突破してきたのです。これはまさに「集合知」の力であり、「三人寄れば文殊の知恵」という古くからのことわざが示す通りです。

この人間社会の知恵は、AIの世界にも同じように当てはまると私は考えています。

ChatGPTやGemini、DeepSeekといった最先端のAIモデルは、目覚ましい速さで進化を続けていますが、それぞれが独自の学習データや学習方法からくる「個性」を持っています。

あるモデルはプログラミングが得意だったり、別のモデルは創造的な文章を書くのが得意だったり、また別のモデルは一連のタスクを順序立てて実行するのが得意だったりと、その強みや弱みは様々です。

私は、これらのAIが持つ「個性」や「偏り」を、単なる限界と捉えるのではなく、むしろ「集合知」を生み出すための貴重な資源だと感じています。

まるで多様な専門家が集まって複雑な問題を解決する「ドリームチーム」のように、AIたちもそれぞれの得意なことを持ち寄って協力し合うことで、単独では解決不可能な問題にも挑めるようになるはずです。

AIの「考える力」を伸ばす:推論時スケーリングという考え方

皆さんは、難しい問題に直面した時、どうしますか?

ほとんどの場合、「時間をかけてじっくり考える」か、「実際に手を動かして試行錯誤する」、あるいは「他の人と協力する」といった方法を取るのではないでしょうか。この人間の問題解決のやり方を、AIにも応用できないか、という発想から生まれたのが「推論時スケーリング」という考え方です。

AIの性能向上については、これまでモデルの訓練時にどれだけの計算資源を使うか(学習時スケーリング)が重要だと考えられてきました。

しかし近年、一度学習が終わったモデルに対しても、推論を行う際に多くの計算資源を投入することで、その性能を大きく向上させられることが分かってきたのです。

これは、人間が与えられた問題を「長く考える」ことに相当します。例えば、OpenAIのo1/o3やDeepSeekのR1といった「推論モデル」と呼ばれるAIは、より長い思考の連鎖を生成することで、その能力を飛躍的に高めています。

しかし、単にAIに「長く考えさせる」だけではありません。

私たちが複雑なプログラミングに取り組む際に、コードを書いては動かし、バグを見つけて修正し、時には最初からやり直すという「試行錯誤」を繰り返すように、AIにもそうした過程を効率的に行わせることはできないでしょうか。

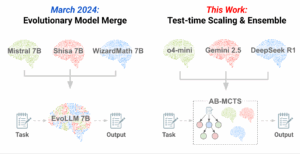

さらに、複数のAIがそれぞれの得意分野を活かして「協力」し合うことはできないでしょうか。Sakana AIが今回発表した新しいアルゴリズム「AB-MCTS」は、まさにこの「試行錯誤」と「協力」という二つの方向から、推論時スケーリングの可能性を追求しています。

AIが賢く「試行錯誤」する:AB-MCTSの仕組み

AB-MCTS(Adaptive Branching Monte Carlo Tree Search)は、LLM(大規模言語モデル)に効率的な「試行錯誤」をさせるための推論時スケーリング手法です。

これまでの試行錯誤の方法には、大きく分けて二つの単純なやり方がありました。

一つは「シーケンシャル・リファインメント」と呼ばれる、「深掘り」する探索方法です。

これは、LLMに答えを生成させた後、それを何度も繰り返し修正していくアプローチです。しかし、最初の答えの方向性が間違っていると、どんなに修正を加えても良い答えにたどり着けないことがあります。

もう一つは「反復サンプリング」と呼ばれる、「広がり」を生む探索方法です。

これは、同じ質問をLLMに複数回繰り返し投げかけ、異なる答えをたくさん生成させる方法です。一見非効率に見えますが、LLMの持つ多様な出力を引き出すことで、多くのベンチマークで高い性能を示すことが報告されてきました。ただし、この方法は有効ではあるものの、完璧ではない解決策そのものを改善することはできません。

これまで、「深く掘り下げる」ことと「幅広く探す」ことの両方が、LLMでより良い答えを見つけるのに有効だと分かっていましたが、これらを効果的に組み合わせる方法がありませんでした。

そこでAB-MCTSは、問題や状況に合わせて、「深掘り」と「広がり」の両方向を柔軟に探索することを可能にしました。

AB-MCTSは、あのAlphaGoにも使われた「モンテカルロ木探索(MCTS)」を拡張したものです。

MCTSは通常、探索の幅が固定されていますが、AB-MCTSではこの制約を取り払い、LLMの持つ無限とも言える出力の多様性を最大限に活かすように設計されています。

具体的には、探索の各段階(ノード)で、全く新しい解決策を生み出す「広がり」と、既存の有望な解決策を改善する「深掘り」のどちらに進むかを、「トンプソンサンプリング」という確率的な方法で賢く決定します。

これにより、同じ計算資源を使うにしても、既存の方法よりも優れた答えを見つけられるようになったのです。

まるで、人間が時には「よし、これは新しいやり方を試してみよう!」と発想を広げ、またある時には「もう少しこのアイデアを煮詰めてみよう」と深掘りする、そんな柔軟な思考プロセスをAIが再現しているかのようです。

AIたちが「知恵」を出し合う:Multi-LLM AB-MCTSの登場

AB-MCTSによって、AIが賢く試行錯誤できるようになっただけでも素晴らしいことですが、Sakana AIの挑戦はさらに進んでいます。それが、複数の異なるLLMが協力し合う「Multi-LLM AB-MCTS」です。

前述の通り、最先端のLLMはそれぞれに異なる得意分野を持っています。あるAIは全体的な戦略を立てるのが得意でも、別のAIは特定のコードを書くのが得意、といった具合です。

こうした異なる「個性」を持つAIたちを単に寄せ集めるだけではなく、それぞれの強みが最大限に発揮できるように「協力」させることができれば、単一のモデルでは解決できなかった問題も、AIたちの「集合知」によって解決できるはずです。

Multi-LLM AB-MCTSは、これまでのAB-MCTSの仕組みに加えて、「どのLLMを使うか」という選択肢を新たに組み込みました。探索の途中で、新しい解決策を「生み出す」(Go Wider)のか、既存の解決策を「洗練させる」(Go Deeper)のか、という選択肢に加えて、「どのLLMを使うか」を適応的に選ぶのです。

この「どのLLMを選ぶか」という問いは、機械学習の世界で「マルチアームバンディット問題」として知られる課題に似ています。

これは、いくつかのアーム(選択肢)があるスロットマシンで、どれを引けば一番大きな報酬が得られるかを、試しながら見つけていく問題です。

Multi-LLM AB-MCTSでは、探索が進むにつれて各LLMのパフォーマンスデータが蓄積され、それを基に「この状況では、どのLLMが最も良い答えを出す可能性が高いか」を、やはりトンプソンサンプリングという確率モデルを使って決定します。

つまり、最初は様々なLLMをバランス良く使いながら、より有望だと分かったLLMに徐々に使用頻度を集中させていく、という賢い戦略を取るわけです。

難問「ARC-AGI-2」での驚くべき成果

このMulti-LLM AB-MCTSの威力を試すため、Sakana AIは非常に難しいベンチマークである「ARC-AGI-2」で実験を行いました。

ARC-AGI(Abstraction and Reasoning Corpus)は、一般的な知識や特定のスキルを問う従来のAI評価とは異なり、人間のような柔軟な推論力や、新しい問題を効率的に解決する能力を評価するために作られたものです。

ARC-AGI-1でさえAIにとっての大きな挑戦でしたが、今回はさらに難易度の高いARC-AGI-2が選ばれました。

実験では、最大250回のLLM呼び出し(計算資源の予算)を設定し、モデルには推論ルールをPythonコードとして生成させました。

生成されたコードがいくつのデモンストレーションケースを正しく解決できるか、という基準で評価(報酬)を行い、最終的に「Pass@k」という指標で性能を測りました。これは「k回以内の試行で少なくとも1つの正しい解決策が見つかったか」を測るもので、探索能力そのものに焦点を当てています。

その結果は、非常に驚くべきものでした。

- 反復サンプリングの限界を超えるAB-MCTS: o4-miniという単一のモデルを使った反復サンプリング(広がり探索)は、問題の23%を解決できましたが、AB-MCTSを使うことで、その成功率は27.5%に向上しました。特に50回以上のLLM呼び出しをすると、AB-MCTSの優位性が明確になったそうです。

- 「集合知」が道を拓く: そして、Multi-LLM AB-MCTSが真価を発揮しました。o4-mini、Gemini-2.5-Pro、DeepSeek-R1-0528という複数の最先端モデルを組み合わせることで、最終的に問題の30%以上で正しい解決策を見つけることに成功したのです。

- 「個性」の融合: 興味深いことに、DeepSeek-R1-0528は単独では特に高い性能を示さなかったにもかかわらず、Multi-LLM AB-MCTSに組み込まれることで、解決できる問題の数を効率的に増やしました。これは、単に一番得意なLLMを使うのではなく、それぞれのLLMの特性を理解し、補完し合うことで全体の性能が向上するという「集合知」の力が明確に示された例と言えるでしょう。

特に印象的なのは、どの単一のLLMも解決できなかった問題が、複数のLLMの協調によって解決された事例です。

例えば、ある問題ではo4-miniが生成した最初の解決策は間違っていましたが、DeepSeek-R1-0528とGemini-2.5-Proがそれをヒントとして活用し、次のステップで正しい解決策にたどり着いたそうです。

これは、Multi-LLM AB-MCTSが、まるで人間のチームのように、互いの失敗から学び、補強し合うことができる柔軟な協力体制をAIにもたらすことを示しています。

Tak@の視点:技術と創造が交差するAIの未来

システムインテグレーターとして、私はこれまで工場の生産管理システムから医学部の複雑な時間割ソフト、大規模な基幹系システムのリプレイス、そして物理媒体を扱う図書館システムまで、本当に多岐にわたるシステム開発に携わってきました。

その中で、システムの根幹を理解し、技術を応用する力を磨いてきたと実感しています。

一方で、15年以上前から趣味でWebサービス開発を始め、「生成AIこそが究極のマッシュアップツールだ!」という確信を持って、日々の「あったらいいな」を形にするツール作りに夢中になっています。

今回Sakana AIが発表したAB-MCTS、特にMulti-LLM AB-MCTSは、まさに私のこうした経験と、生成AIが持つ無限の可能性への情熱が交差する点にあると感じました。

これまで個々のAIモデルの能力を競うことが多かったAI開発の世界に、「協力」という新しい視点が加わることは、まるで新しい風が吹き込むような感覚です。

私の開発している「AI学習プランナー」や「AI業務自動化提案サービス」、「AIプログラマー」といったツールも、AIの力を借りて「人の創造活動を助ける」ことを目指しています。

個々のAIが持つユニークな能力を、単体で使うだけでなく、複数のAIを連携させ、まるで人間チームのように協調させることで、これまで以上に複雑で創造的な課題を解決できる可能性が広がります。

これからのAIと私たちの関わり

Sakana AIの研究は、AIの推論時スケーリングにおいて、まだ誰も手を付けていないような大きな可能性を秘めていることを示唆しています。

2024年中頃から注目されてきた「推論モデル」が、「長く考える」ことでAIの能力を高めてきたのに対し、今回のAB-MCTSはそれに加えて「試行錯誤」と「集合知」という新しい方向性を提示しています。

もちろん、課題がないわけではありません。例えば、今回の実験で使われた「Pass@k」という評価指標は、探索能力そのものを見るものであり、実際のコンテストで求められる「Pass@2」(2つの最終回答の中から正しいものを選ぶ)とは異なる部分があります。

このギャップを埋めるためには、より洗練された最終回答の選択アルゴリズムや、LLM自体を評価者として使う「LLM-as-a-Judge」といった、さらなる研究が必要だとされています。

また、Multiagent Debate、Mixture-of-Agents、LE-MCTSといった他のAI協調手法との関係性も、今後の研究で深掘りしていくべき分野です。

しかし、これらの課題があるからこそ、AIの未来はさらに面白くなると私は思います。

AIが単なる高性能な計算機ではなく、まるで私たち人間のように「試行錯誤」し、互いに「協力」し合う存在になるとしたら、それは私たちの生活や仕事に計り知れない影響を与えるでしょう。

Sakana AIは、これからも「進化」と「集合知」という自然からヒントを得た原則をAI開発に応用していくとのことです。

私は、技術と創造力を駆使して、皆さんの「アイデアを形にする」お手伝いができればと思っています。AIが「協力」という新たな力を手に入れたことで、これからどんな「これまでできなかったこと」が実現されていくのか、私も一人の開発者として、そしてAIユーザーとして、とても楽しみにしています。