AIの「無法地帯」に終止符? Stability AIの規約改定が示す未来

こんにちは、システムインテグレーターのTak@です。さて、皆さんは最近、あるニュースがAI業界に大きな衝撃を与えたことをご存じでしょうか?

それは、AIモデルの自由な開発と利用に、これまでにない「待った」をかけるような出来事でした。

わずか数日のうちに、これまでは自由に、ある意味“野放し”に生成できたAIコンテンツに、突然、厳格なルールが課せられることになったのです。

新たな波紋を呼ぶStability AIの規約改定:何がどう変わるのか

2025年7月31日、AIの「自由」に新たな境界線

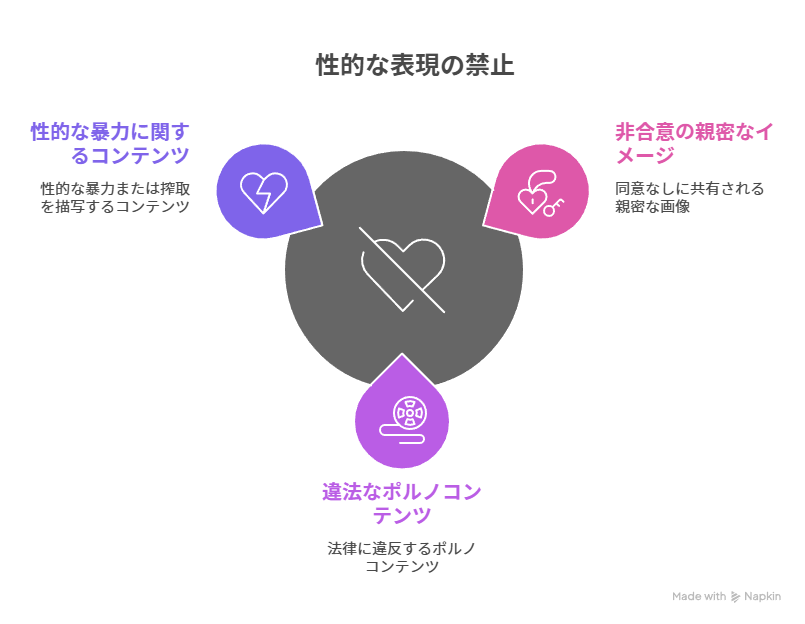

2025年7月31日、画像生成AI「Stable Diffusion」の開発元であるStability AIが、新しい利用規約を施行します。この改定は、特に「性的コンテンツの生成を全面的に禁止する」という点で、大きな注目を集めています。

Acceptable Use Policy — Stability AI

具体的に禁止されるのは、非同意の親密な画像(NCII)、違法なポルノコンテンツ、性行為や性的暴力に関連するコンテンツ、そして児童に関連する性的表現(CSAM)などです。

これまでの規約でも違法なコンテンツは禁止されていましたが、今回は「性的内容そのもの」が制限対象となりました。

この新しい規約の対象範囲は非常に広く、Stability AIのモデル、製品、サービス、API、ソフトウェア、その他の資料といった「Stability AI Technology」のすべてに及びます。

これには、自社でStable Diffusionのコードや「重み」(モデルデータ)を動かす「ローカル環境」での利用や、サードパーティのプラットフォームを通じた利用も含まれます。もし規約に違反した場合、アカウントの停止や凍結、さらには関係当局への通報といった厳しい措置が取られる可能性も明記されています。

私は、このニュースに初めて触れた時、AIの進化が社会に与える影響の大きさを改めて痛感しました。これまで技術的な観点から「できること」を追求してきたAIが、今度は「やるべきではないこと」に強く直面していると感じたのです。

「ローカルだから大丈夫」は通用するのか?:ライセンスと利用規約の複雑な関係

今回の規約改定を受けて、特にユーザーの間で議論が活発になっているのが、「手元のパソコン(ローカル環境)で動かす分には問題ないのではないか」という点です。

この背景には、過去に公開されたStable Diffusionのモデル、例えば「Stable Diffusion 1.5」や「Stable Diffusion XL(SDXL)」が、「取り消し不可能(irrevocable)」なライセンスで提供されているという事実があります。

これは、一度公開されたものに後から利用制限を加えることはできない、という考え方に基づいています。また、ローカルで利用するモデルは追跡が難しいため、技術的な規制は困難だという声もあります。

確かに、7月31日以前にリリースされたモデルを使用し、それが取り消し不可能なライセンスの下で提供されているのであれば、個人利用や商用利用においても、従来の通りコンテンツ生成に制限はない、と考えることができます。

実際に、AIを使った物販や同人誌作成においては、SDXL以前のモデルを使っている限りは、既存の商用利用権利が維持され、法的な問題は生じないだろうと予測されています。

しかし、Stability AIは新しい規約の中で、「Stability AI Technologyを使用した時点で、このポリシーに同意したものとみなす」と明確に述べています。これは、例え古いモデルを使っていたとしても、今後の利用行為そのものが新規約の対象になる可能性を秘めている、と解釈できます。

将来的にはモデルの配布経路や利用ツールの監視強化、あるいはモデル自体に利用制限を透かしなどを組み込む技術の発展によって、ローカル利用も完全に「無法地帯」ではなくなる可能性があるのです。

生成されるコンテンツの内容が問題視されれば、「古いモデルだから大丈夫」とは言い切れない状況があるのです。

また、「Google Colab」のようなクラウドサービスでは、既にアダルトコンテンツの生成が禁止されており、NSFW(Not Safe For Work)コンテンツのフィルタリングが導入されています。

7月31日以降は、Stability AI側とGoogle側の二重の制限がかかることで、さらに厳格なチェック体制になると予想されています。これは、技術的な側面だけでなく、プラットフォーム側の「意向」や「外部からの圧力」が、モデルの配布やアクセスに影響を与える可能性を示唆しています。

この状況は、私たちがAI技術を利用する上で、単に技術的な側面だけでなく、「誰が、どのような意図で、その技術を使うのか」という利用行為そのものに、より一層の責任が求められる時代に入ったことを示していると私は思います。

「責任あるAI」の時代へ:法的・倫理的な地殻変動

AI生成コンテンツと著作権:見えない「グレーゾーン」の行方

AIの進化は、著作権に関する新たな問題も投げかけています。生成AIは、膨大なデータを学習することで新しいコンテンツを生み出しますが、この学習データには著作権で保護された作品が多数含まれています。

日本では、著作権法第30条の4に基づき、AI開発のための学習目的での著作物利用は、一定の条件下で許諾なく行うことができるとされています。しかし、これは無制限ではなく、単なる模倣や再現を目的とした利用は区別して考える必要がある、という見解も示されています。

さらに、AIが生成したコンテンツそのものの著作権は、各国で異なる考え方が示されています。

日本では「人間の創作性」が著作物の要件とされており、AIが完全に自律的に生成したコンテンツは著作物として保護されないのが一般的です。しかし、人間が創作的な手を加えた場合や、AIへの指示(プロンプト)に創作性が認められる場合には、保護される可能性があります。

アメリカでも同様に、詳細で創造的なプロンプトは著作権保護の対象となり得る、とされています。

プロンプトの記述一つで、意図せず著作権侵害のリスクを抱える可能性があるというのは、まさにデジタル時代の新たな課題だと感じます。特定のアーティストの作風を模倣するような指示をAIに与えることは、著作権侵害につながる可能性があり、実際に批判や法的措置が取られる事例も増えています。

「擬似的児童ポルノ」が突きつける法制度の限界

Stability AIの規約改定の背景には、AIが生成する児童の性的虐待コンテンツ(CSAM)の急増という深刻な社会問題があります。この問題は、AIがもたらす新たな法的課題を浮き彫りにしています。

これまでの日本の児童ポルノ禁止法は、「実在する児童の姿態」を描写したものを対象としており、AIによって作られた「擬似的児童ポルノ」は原則として処罰の対象外とされてきました。

顔は実在する児童だが体が別人やAI生成である場合など、識別が難しいケースも多く、その判断は容易ではありません。

この問題は、従来の「モーフィング」や「コラージュ」といった技術による擬似的コンテンツとは、質的な違いがあるというよりも、AIによって「いとも簡単に、安価に、質の高いものが大量に作成できるようになった」という量的な要因によって、より深刻になっていると考えられています。

技術が先行し、法整備が追いつかない現状は、プロジェクト管理において、予測不可能な事態やリスクにどう対処するかという視点に似ています。AIの世界ではまさに技術の進歩と法制度のギャップとして現れています。

名誉毀損罪や侮辱罪といった既存の法律で対処しようとする試みもありますが、生成された画像の質や、それが「社会的評価の低下」につながるかどうかの判断は難しく、十分な対応ができない場合もあります。

より根本的な問題として、「自己像の同一性に対する権利」といった個人の人格権侵害を軸とした議論が、今後さらに重要になってくるでしょう。

グローバル規制の波と「Responsible AI」の必要性

このようなAIを取り巻く法的・倫理的な課題に対し、世界各国で規制の動きが加速しています。欧州では、2024年5月に世界初の包括的なAI規制法「EU AI Act」が成立し、韓国でも2024年12月にアジア初のAI法が可決されました。

これらの法律は、AI開発・利用のリスクを管理し、信頼性の高いAIシステムを構築することを目的としています。

特に注目すべきは、「責任あるAI(Responsible AI)」という考え方です。これは、AIの設計、開発、導入、利用において、社会への影響を考慮し、倫理原則と整合させるための一連の指針です。具体的には、「説明可能性」(AIの判断理由が分かること)、「公平性」(偏見がないこと)、「堅牢性」(異常な状況にも対応できること)、「プライバシー」(個人情報保護)、「透明性」(AIの仕組みが理解できること)といった「信頼の柱」が提唱されています。

企業や個人がAIを安全に活用していくためには、単に「使えるから使う」という姿勢ではなく、これらの責任あるAIの原則を理解し、自身の活動に取り入れていくことが不可欠です。これは、AI技術の発展と健全な社会の両立を目指す上で、避けては通れない道だと私は考えています。

私たちに問われる「AIとの付き合い方」:SIerからの提言

企業が今すぐ取り組むべき「リスク回避策」

今回のStability AIの規約改定や、AIを取り巻く法的な動きは、企業や個人事業主にとって、AIの活用方法を再考する良い機会です。私はSIerとして、以下のようなリスク回避策を提言します。

- 社内AI利用ポリシーの策定と運用

- どのAIツールを使うか、社内データをどう扱うか、AI生成コンテンツをどこまで外部に出して良いか、といった明確なルールを作るべきです。

- 定期的な研修や情報共有を通じて、従業員のリテラシーを高めることが重要です。

- AIプロンプトの作成と管理の徹底

- 特定のアーティストの作風を真似るような指示は避けるべきです。また、「〜のような」「〜風」といった表現も、著名な作品を指す場合は注意が必要です。

- プロンプトは詳細かつ具体的に記述し、その記録を保存しておくことで、万が一の際に「証拠」として提示できるようにします。

- AI生成コンテンツのレビュープロセスの確立

- AIが作ったものをそのまま使うのではなく、必ず人間が内容を確認し、既存の著作物との類似性がないかをチェックする体制を整えるべきです。

- 必要に応じて、法律の専門家など外部の意見も取り入れることが大切です。

- AIベンダーとの契約・利用規約の精査

- 利用するAIサービスの規約をよく読み、商用利用が許可されているか、生成物の著作権がどうなるか、責任分担はどうなっているか、といった点を細かく確認しましょう。

- 企業の規模や用途によっては、標準規約では不十分な場合もあるため、個別の契約交渉も視野に入れるべきです。

- 著作権教育とリスク意識の醸成

- AI技術は日々進歩し、法制度も変化しています。継続的に最新情報を学び、著作権やAIに関する正しい知識を身につけることが、すべての関係者に求められます。

AIの「自由な設計」と「社会的な責任」のバランス

今回のStability AIの規約改定は、「技術の自由」と「倫理的な制御」の間にある深い溝を改めて私たちに示しました。オープンソースとして広く公開されているStable DiffusionのようなAIモデルは、その性質上、企業が規約を設けても、その制限を「すり抜ける」ことが構造的に可能です。

実際、規約に従わない「フォークモデル」が登場したり、技術的な規制が難しい「匿名掲示板」や「Torrentサイト」でのモデル配布が続いたりする可能性も指摘されています。

これは、「規約は正しさを示すことはできても、完全な歯止めにはなり得ない」という現実を突きつけます。規制が厳しくなればなるほど、企業が提供する正規のルートから外れて、より自由な(しかしリスクのある)利用へと向かう傾向が強まるかもしれません。

この変化は、AIが単なるツールではなく、社会のインフラとして成長していく上での重要な通過点だと考えています。

技術的な側面だけでなく、「どのような表現が社会として受け入れられるのか」「それを誰が決めるべきなのか」といった、より根源的な「社会設計」の問いが私たちに突きつけられているのだと私は感じています。

しかし、このような状況だからこそ、前向きな動きも生まれています。例えば、「Flux Schnell」や「Black Forest Labs」のような、より自由な利用条件を提供する新しいAIモデルや開発元が登場しています。これは、制約が逆に技術の発展や多様化を促し、健全な競争環境を生み出す可能性を示しています。

最後に:あなたは、AIとどう向き合いますか?

今回のStability AIの規約改定は、AIという新しい技術が、私たちの社会や価値観にどれほど深く影響を与えるかを改めて考えさせる出来事でした。単に「AIができること」だけでなく、「AIが社会としてどうあるべきか」という問いに、私たちは向き合わなければなりません。

AIは、すでに私たちの生活や仕事に深く入り込んでいます。それは決して止まることのない流れです。だからこそ、私たちはAIの進化を単に受け入れるだけでなく、「どのように使っていくか」という「自由の設計」について、これまで以上に慎重かつ主体的に考える必要があります。

倫理的な行動とは何か、抑圧的ではない自由とは何か。その線引きは、技術を開発する者、サービスを提供する者、そしてそれを利用する私たち一人ひとりの手にかかっています。

あなたは、この大きな変化の中で、AIとどのように向き合い、どのように社会を築いていきたいと考えますか?